Hosting seoSEO (Search Engine Optimization) to proces optymalizacji strony internetowej lub treści online w taki sposób, aby była lepiej widoczna i rankowana przez wyszukiwarki internetowe, takie jak Google, Bing czy Yahoo. Głównym celem SEO jest zwiększenie ruchu organicznego na stronie poprzez poprawę jej pozycji w wynikach wyszukiwania dla określonych słów kluczowych. Jak działa SEO? SEO opiera się na trzech głównych filarach: Optymalizacja techniczna – Zapewnienie, że strona działa sprawnie, szybko się...Czym jest SEO? – prawda czy mit? Czy istnieją hostingi lepsze i gorsze pod kątem widoczności w wyszukiwarkach? Niedawno[esi renderUserFirstName cache=”private” ttl=”86400″ prefix=”, ” suffix=”,”] na jednej z facebookowych grup zauważyłem pytanie: „Czy hosting może wpływać na seo mojej strony?” Postanowiłem napisać krótki artykuł, w którym wyjaśniam, jakie są potencjalne relacje pomiędzy hostingiem i Twoimi pozycjami w wyszukiwarce Google.

Ten materiał jest przeznaczony dla:

- osób, które zadają sobie pytanie, czy wybór hostingu wpłynie na ich pozycje w wynikach wyszukiwania,

- zakładających stronę www po raz pierwszy, którym zależy na hostingu sprzyjającym osiąganiu wysokich pozycji,

- specjalistów seo, którzy wyczerpali inne możliwości wpływania na pozycje i zastanawiają się teraz, czy zmiana hostingu może poprawić wyniki.

Zanim zaczniemy mówić o hostingu seo

To dość rozległy wpis o hostingu w kontekście seo. Jeśli należysz do osób, które wolą obejrzeć szybkie video – przygotowałem ten materiał w formie kilkuminutowego filmu, streszczającego najważniejsze elementy.

Hosting seo a szybkość wczytywania strony

Google na swoim oficjalnym blogu mówi o roli szybkości w budowaniu rankingu już od 2010 roku W 2018 pojawia się informacja o tym, że oficjalnie szybkość będzie brana pod uwagę jako czynnik

rankingowy przy kształtowaniu wyników mobilnych a w 2020, w maju, pojawia się informacja

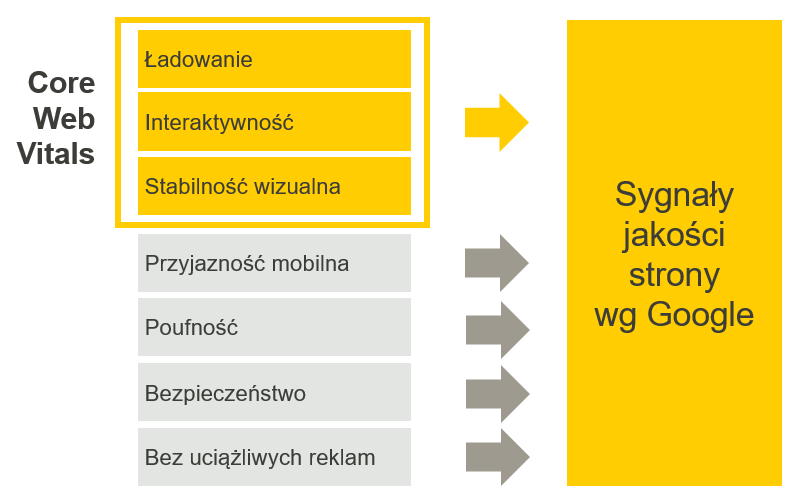

o Core Web VitalsCWV (Core Web Vitals) to zestaw wskaźników opracowanych przez Google, mających na celu ocenę jakości doświadczenia użytkownika na stronach internetowych. Wskaźniki te koncentrują się na trzech kluczowych aspektach: szybkości ładowania strony, interaktywności oraz stabilności wizualnej. Najważniejsze wskaźniki CWV LCP (Largest Contentful Paint) - mierzy czas potrzebny na załadowanie największego elementu treści na stronie. Optymalny czas to poniżej 2.5 sekundy. FID (First Input Delay) - mierzy opóźnienie w reakcji strony na pierwszą interakcję użytkownika...Czym jest CWV?, czyli takich najważniejszych z punktu widzenia szybkościowego parametrach

strony internetowej i o tym, że będą one wpływać na kształtowanie wyników wyszukiwania.

Google mówi o tym, że będzie oceniać strony internetowe przez pryzmat siedmiu grup czynników,

z czego aż trzy wiążą się bezpośrednio z zagadnieniem szybkości.

Są to:

Largest Contenful Paint, czyli czas wyrenderowania największego elementu, największej części strony internetowej.

First Input Delay – czas do momentu, kiedy strona uzyskuje interaktywność, czyli kiedy możesz klikać i wejść w jakąś interakcję z tą stroną internetową.

Visual Stability Index – na pewno znasz to uczucie zwłaszcza na urządzeniu mobilnym, kiedy wchodzisz na jakąś stronę i ona tak się zmienia, zmienia, zmienia kiedy się doładowują kolejne elementy, aż w końcu zastyga w takiej swojej docelowej formie. No i właśnie to zmienianie się jest tutaj przedmiotem zainteresowania Google’a.

Te czynniki są nieprzypadkowe, one wynikają z troski o doświadczenie użytkownika. Tyle się dowiadujemy z oficjalnych materiałów Google’a Trudno kwestionować tego typu wiedzę. Natomiast zapytałem również praktyków, specjalistów między innymi Łukasza Suchego z Devagroup czy Grześka Strzelca autora kursu Papaseo, a więc dwie osoby cieszące się raczej dużym autorytetem w polskim świecie seo no i obie z tych osób wypowiedziały się z pewną rezerwą, zauważając, że tak naprawdę nie zauważyły istotnego wzrostu pozycji w wyniku tego, że strona zaczęła się szybciej ładować.

Wróćmy jednak do opinii na temat szybkości jako czynnika rankingowego. Jednym z najbardziej rozpoznawalnych ekspertów w Polsce jest autor unikatowego szkolenia Papa Seo, Grzegorz Strzelec. O opinię poprosiłem także Łukasza Suchego z Deva Group.

OPINIA EKSPERTA

Co prawda jest to czynnik pośredni dla SEO (choć kluczowy biznesowo) i poza skrajnymi przypadkami stron, które się po prostu ładują w nieskończoność, nigdy nie zaobserwowałem, aby różnica w ładowaniu o sekundę czy 3 sekundy, mogła wpłynąć w sposób bezpośredni na SEO.

Grzegorz Strzelec,

ekspert seo, właściciel papaSeo.com

Łukasz Suchy,

ekspert SEO i SEMSEM (Search Engine Marketing) to strategia marketingowa, która obejmuje płatne działania mające na celu promowanie strony internetowej poprzez wyświetlanie reklam w wynikach wyszukiwania lub na innych platformach reklamowych. Głównym celem SEM jest zwiększenie widoczności i ruchu na stronie poprzez reklamę w wyszukiwarkach internetowych. SEM składa się głównie z płatnych kampanii reklamowych w wyszukiwarkach, które pozwalają na dotarcie do użytkowników w momencie, gdy szukają oni konkretnych produktów lub usług. W przeciwieństwie...Czym jest SEM? z devagroup.pl

OPINIA EKSPERTA

W swojej pracy nie zauważam bezpośredniego wpływu szybkości działania strony na jej ranking w wynikach wyszukiwania. Szczególnie dobrze widać to na stronach, na których poprawa rzędu 2-3 sekund nie daje zauważalnych efektów dla SEO. Jednak, szybkość wczytywania strony jest dla mnie ważnym elementem i czynnikiem w ogólnym odbiorze stron – w końcu jako seowcy mamy swoimi działaniami pomóc klientom w dotarciu do szerszej grupy odbiorców i doprowadzić do jak największej liczby konwersji. Co prawda wkracza to nieco w dział UX – szybkość ma bowiem wpływ na konwersje w serwisie oraz wygodę użytkowników. Poprawa szybkości ma zatem pośredni wpływ na wyniki SEO :). Widoczny jest również coraz mocniejszy nacisk na szybkość działania serwisów ze strony samego Google. Mamy przecież Core Web Vitals, które ciągle zyskuje na znaczeniu. Dodatkowo, w połowie 2021 r. czeka nas kolejna duża aktualizacja poświęcona szybkości i UX.

Mimo faktu, że doświadczeni eksperci są sceptyczni, to również zauważają, że szybkość ładowania strony jest ważna, ponieważ wpływa też na inne elementy, na przykład na Quality Score w systemie Google AdsGoogle Ads (dawniej znany jako Google AdWords) to platforma reklamowa firmy Google, która umożliwia firmom promowanie swoich produktów i usług poprzez wyświetlanie reklam w wynikach wyszukiwania Google oraz na stronach partnerów Google, takich jak strony internetowe, aplikacje mobilne, czy platformy wideo. Jak działa Google Ads? Google Ads opiera się na modelu płatności za kliknięcie (PPC), co oznacza, że reklamodawcy płacą tylko wtedy, gdy użytkownik faktycznie kliknie na ich reklamę. Platforma...Czym jest Google Ads? oraz – przede wszystkim – na współczynnik odrzuceńBounce Rate czyli czyli po polsku współczynnik odrzuceń, to wskaźnik używany w analityce internetowej. Określa procent użytkowników, którzy opuścili stronę internetową po obejrzeniu tylko jednej podstrony, nie wykonując przy tym żadnej dodatkowej interakcji (np. kliknięcia w link, wypełnienia formularza, przejścia na inną zakładkę). Bounce Rate to również wskaźnik używany w e-mail marketingu. Jego analiza pozwala m.in. na weryfikację baz e-mail marketingowych. Współczynnik odrzuceń mierzy procent wiadomości e-mail, które nie zostały...Czym jest Bounce Rate? i na współczynnik konwersjiW kontekście marketingu internetowego i analizy danych, konwersja oznacza pożądaną akcję lub cel, który użytkownik podejmuje na stronie internetowej lub w aplikacji. Konwersja może przyjmować różne formy, w zależności od celów biznesowych, takich jak np.: Zakup: Przeprowadzenie transakcji, zakupu produktu w sklepie internetowym lub usługi na stronie internetowej. Rejestracja: Zapisanie się do newslettera, utworzenie konta użytkownika, wypełnienie formularza rejestracyjnego lub rejestracja na wydarzenie. Pobranie: Pobranie pliku, np. e-booka, raportu, aplikacji...Czym jest Konwersja?.

Trudno powiedzieć, jak sytuacja będzie wyglądać w 2021, bo Google będzie wdrażać mechanizmy oparte o czynniki Core Web Vitals. Jako przygotowanie do tego procesu popularny test PageSpeedPageSpeed to narzędzie stworzone przez Google, które służy do analizy wydajności stron internetowych. Ocena dokonywana jest zarówno dla wersji mobilnej, jak i desktopowej witryny. PageSpeed ocenia szybkość ładowania strony oraz proponuje konkretne rozwiązania, które mają na celu poprawę jej wydajności. Wynik prezentowany jest w skali od 0 do 100 – im wyższy wynik, tym lepiej zoptymalizowana strona. PageSpeed to nie tylko liczba – to kompleksowe narzędzie, które pomaga właścicielom stron...Czym jest PageSpeed? już teraz sprawdza te właśnie parametry:

Hosting, seo i limity bezpieczeństwa

Kolejny element, który warto wziąć pod uwagę wybierając hosting, to tak zwane limity bezpieczeństwa. Większość hostingów współdzielonych ma te limity ustalone po to, żeby zachować stabilność serwerów oraz uruchomionych na nich usług.

I teraz, kiedy Twoja strona jest napisana w sposób daleki od optymalnego kiedy masz duży ruch i umieszczasz tą stronę na jednym koncie hostingowym z jeszcze innymi stronami, no to jest spora szansa, że zaczniesz przekraczać te limity! Z mojego doświadczenia hostingowego wynika, że najczęściej przekraczanym limitem jest limit jednocześnie uruchomionych procesów PHPPHP - (Hypertext Preprocessor) to jeden z najpopularniejszych języków skryptowych, używany przede wszystkim po stronie serwera do tworzenia dynamicznych stron internetowych. Powstał w 1995 roku, a jego twórcą jest Rasmus Lerdorf. PHP cechuje się prostą składnią, dużą elastycznością oraz ogromną społecznością, która stale rozwija ten język. Dzięki temu PHP jest świetnym wyborem zarówno dla początkujących programistów, jak i zaawansowanych deweloperów tworzących rozbudowane aplikacje webowe. Jednym z głównych zastosowań PHP jest...Czym jest PHP?.

Jeżeli tak się dzieje, jeśli dochodzi do wysycenia tych limitów bezpieczeństwa i wtedy Twoja strona zostanie zatrzymana, przestanie się otwierać. Wyobraź sobie że właśnie wtedy wchodzi na nią Google Bot – i co wtedy? Wtedy strona akurat nie działa… Tego typu przypadek nie jest wcale rzadkością, mówił o tym na przykład Piotr Michalak podczas spotkania Seo Meetup, organizowanego w we Wrocławiu w grudniu 2018 roku. Opisywał wówczas przypadek sklepu rowerowego, którego indeksowanie przez robota napotkało poważne problemy z powodu… limitów bezpieczeństwa serwera!

Takie problemy mogą się pojawić, kiedy Twój serwis jest średnio napisany i „zgarnia” bardzo dużo ruchu. Kiedy natomiast GooglebotGooglebot to robot internetowy, czyli program komputerowy stworzony i utrzymywany przez firmę Google, który przeszukuje i indeksuje treści dostępne w Internecie w celu ich zaindeksowania w wyszukiwarce Google. Jest to rodzaj webcrawlera, który automatycznie przeszukuje strony internetowe, analizując zawartość witryn w celu zrozumienia ich treści i struktury. Przechodzi przez strony internetowe, śledzi linki i zbiera informacje na temat zawartości każdej strony - tekst, obrazy, linki, metadane i inne elementy. Googlebot...Czym jest Googlebot? wchodzi na Twoją stronę i ona się nie otwiera – łatwo się domyślisz: nie wpływa to dobrze na Twoją wiarygodność w oczach wyszukiwarki.

Ataki sieciowe a hosting seo

Również, jeśli chodzi o odporność na ataki sieciowe, firmy hostingowe różnią się między sobą. Jedne firmy mają większą, inne mniejszą zdolność do radzenia sobie na przykład z atakami typu DDoS.

Kiedy taki atak zostanie wycelowany w serwerhttps://www.youtube.com/watch?v=EOt63g4cEss Co to jest serwer? To komputer lub system komputerowy, który udostępnia zasoby, usługi lub dane innym komputerom, zwanym klientami, za pośrednictwem sieci (np. Internetu). Działa on na zasadzie modelu klient-serwer, gdzie serwer odpowiada na żądania wysyłane przez klientów. Serwer to fundament działania usług internetowych. Umożliwia dostępność stron www, obsługę poczty, przechowywanie danych i realizację wielu innych funkcji sieciowych. Czym fizyczny serwer różni się od zwykłego komputera? Fizyczny serwer może...Czym jest Serwer?, na którym znajduje się Twoja strona i skutecznie położy nie tylko Twoją stronę, ale tak naprawdę cały serwer, a firma hostingowa w ramach obrony może po prostu wyłączyć Twój serwis. Znowu zatem – jeśli Googlebot będzie w tym samym momencie próbował dostać się do Twojej strony, to wpłynie negatywnie na Twoją reputację w oczach wyszukiwarki i raczej będzie to sprzyjać obniżaniu Twojej pozycji w wynikach wyszukiwania.

Redakcja Pracawsieci.net

Zwracamy dużą uwagę na szybkość ładowania stron w przypadku wyboru hostingu. Ma to nie tylko wpływ na SEO, ale też na ogólny UX witryny – czyli na to, na czym każdemu najbardziej zależy. Wybór hostingu oraz odpowiednia optymalizacja ma tutaj kluczowe znaczenie.

Niezawodność hostingu a Twoje wyniki seo

Idąc tropem nieutrudniania procesu indeksowana treści Googlebotowi można śmiało przyjąć, że niezawodność stron internetowych bardzo się tutaj liczy. Skoro mamy już jasność co do tego, że zdecydowanie wolisz kiedy strona działa sprawnie podczas odwiedzin zarówno ludzi, jak i robotów, to najlepiej wybierać te hostingi, które sprzyjają wysokiej niezawodności.

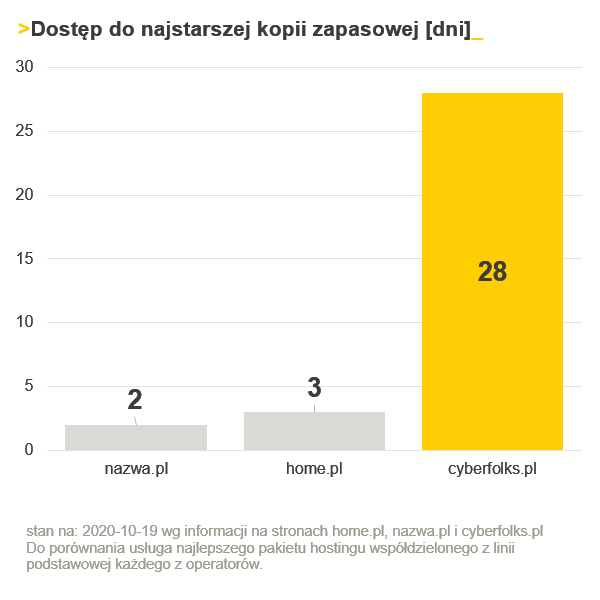

Mam tu na myśli przede wszystkim te, które poza dobrą infrastrukturą zapewniają Ci też dobry dostęp do kopii zapasowych. Bo jeśli Twoja strona zostanie zhakowana, to tak naprawdę w żaden sposób, znowu, nie poprawiasz swojej reputacji. Co gorsza, jeśli Google wykryje infekcję na Twojej stronie, to może radykalnie wpłynąć to na wyniki w Twoim rankingu, a nawet, na przykład, spowodować nagłe wyłączenie reklam w systemie Google Ads.

W takim wypadku możesz chcieć bardzo szybko przywrócić z backupu niezainfekowaną wersję oczywiście ja gorąco rekomenduję przede wszystkim poznanie przyczyny tej infekcji, zanim będziesz przywracał stronę z backupu, natomiast nie ulega wątpliwości, że lepiej ten backupBackup to kopia zapasowa danych, która jest tworzona w celu zabezpieczenia ich przed utratą, uszkodzeniem lub zniszczeniem. Regularne tworzenie backupu jest kluczowym elementem zarządzania danymi, zarówno w kontekście osobistym, jak i biznesowym. Dlaczego backup jest ważny? Backupy są niezwykle istotne, ponieważ pozwalają na odzyskanie danych w przypadku ich utraty spowodowanej awarią sprzętu, atakiem hakerskim, przypadkowym usunięciem czy innymi nieprzewidzianymi zdarzeniami. Dla właścicieli sklepów internetowych czy użytkowników hostingu dla WordPress, regularne...Czym jest Backup? po prostu mieć. Dlatego jest to również rzecz, którą warto brać pod uwagę wybierając firmę hostingową.

W naszej firmie wykonujemy kopie zapasowe codziennie, w planach hostingu dla WordPress i hostingu dla PrestaShop bazy są backupowane nawet częściej, bo co 6 godzin. Dane są przechowywane do 28 dni wstecz – to znacznie dłużej niż u wielu innych operatorów. Polityka kopii zapasowych to zresztą temat na odrębny artykuł, który także znajdziesz na naszym blogu.

DNS Anycast a hosting seo

Kolejny element, to jest technologia DNS Anycast. Moim zdaniem ta technologia może mieć potencjalnie wpływ na Twoje wyniki. Dlaczego tak się dzieje? Dlatego, że technologia DNSDNS, czyli System Nazw Domenowych (Domain Name System), to system umożliwiający przypisanie nazw domen do adresów IP. Dzięki temu, zamiast pamiętać skomplikowane ciągi liczb, które stanowią adres IP danej strony, użytkownicy mogą wpisywać łatwo zapamiętywalne nazwy domen. System Nazw Domenowych został opracowany w latach 80. XX wieku, jako rozwiązanie problemu szybko rosnącej liczby adresów internetowych, co utrudniało ich zapamiętywanie i zarządzanie nimi. Zastąpił on wcześniejszą metodę, polegającą na centralnej edycji i dystrybucji pliku...Czym jest DNS? Anycast pozwoli na szybsze wczytanie strony, jeśli mamy do czynienia z tym, że użytkownik jest oddalony geograficznie od Twoich serwerów. Tak się może dziać w przypadku robota Google.

Jeśli robot Google szybciej wczyta Twoją stronę, szybciej w rozumieniu czasu do pierwszego bajtu odpowiedzi, tzw. TTFB, a na ten czas składa się między innymi czas odpowiedzi serwera DNS, to w takim wypadku masz szansę, że Google weźmie to pod uwagę. Neil Patel, uznawany za autorytet w dziedzinie seo na skalę światową wykonywał tego typu badania i potwierdził, że istnieje korelacja chociaż – powiedzmy sobie to szczerze – nie jest ona bardzo silna, pomiędzy czasem TTFB, czyli Time to First ByteTTFB, czyli Time To First Byte, jest miarą czasu, jaki upływa od momentu wysłania żądania HTTP do serwera, do momentu otrzymania pierwszego byte odpowiedzi z serwera. Innymi słowy, TTFB określa czas, jaki potrzebuje serwer, aby przetworzyć żądanie klienta i wysłać pierwszy bajt odpowiedzi. TTFB jest ważnym wskaźnikiem wydajności strony internetowej, ponieważ odzwierciedla on szybkość reakcji serwera na żądania użytkowników. Im krótszy czas TTFB, tym szybciej strona może zareagować na żądania...Czym jest TTFB?, a pozycją w Google.

Możesz również dla swoich słów kluczowych zadać taką korelację narzędziem surferseo, które serdecznie polecam.

Czy klasa adresowa hostingu ma wpływ na SEO?

Kolejnym kryterium, które warto wziąć pod uwagę jest adres IPCzym jest adres IP?Adresem IP nazywamy adres protokołu internetowego, który jest zestawem liczb przypisanych do urządzenia. Adresy te służą do identyfikacji urządzenia i komunikacji z innymi osobami w Internecie. Jednocześnie adres IP nie jest numerem rejestracyjnym urządzenia. Nie wolno traktować tych pojęć tożsamo. Nie możesz go traktować jako fizycznego numeru urządzenia. Wyróżniamy 2 podstawowe typy adresów IP. To IPv4 oraz IPv6.Adresy IP są nadawane głównie w wersji IPv4. Taką formę...Czym jest Adres IP?. Google mówi, że to, gdzie Ty jesteś geograficznie – ma wpływ na kształtowanie lokalnych wyników wyszukiwania. Twoja pozycja jest ustalana między innymi w oparciu o adres IP. Co za tym idzie – klasy adresowe mogą mieć wpływ na wyniki wyszukiwania, sugerując Google większą przydatność wyników np. stron z tego samego kraju.

Wyniki wyszukiwania jak wiesz, są w coraz większym stopniu spersonalizowane no i nic dziwnego, że jeśli zależy Ci na wysokiej pozycji w rankingu Google w konkretnym kraju, to dobrze, żebyś miał klasę adresową właśnie z niego. Przez wiele lat osobiście opiekowałem się klientem z klastrem dedykowanych serwerów pod ecommerce, ustawionym w Berlinie tylko dlatego, że klientowi zależało na świetnej widoczności w google.de

Powiedzieć jednak jasno należy – na wyniniki SERPSERP (Search Engine Results Page) – to strona wyników wyszukiwania wyświetlana przez wyszukiwarki internetowe, takie jak Google, po wpisaniu zapytania przez użytkownika. SERP składa się zarówno z wyników organicznych, jak i płatnych, które odpowiadają na konkretne zapytanie. Wyniki organiczne są generowane na podstawie algorytmu wyszukiwarki, który analizuje i ocenia treść stron internetowych, podczas gdy wyniki płatne to reklamy, za które firmy płacą, by być wyświetlane wyżej w wynikach. Co znajduje...Czym jest SERP? wpływają głównie klasy adresowe użytkownika kierującego zapytanie, a nie serwera. Lokalizacja serwera nie jest obecnie uznawana za bezpośredni czynnik rankingowy.

Pamiętaj natomiast o wpływie pośrednim, związanym m. in. z rosnącym czasem ładowania strony, kiedy będzie ona daleko od użytkownika.

Złe sąsiedztwo – co oznacza w kontekście hostingu seo?

Złe sąsiedztwo to jest kolejny element, który przejawia się w dyskusjach na temat roli hostingu w SEO. Jeśli chodzi o złe sąsiedztwo, to ja tutaj powiedziałbym za Google, że jest to jeden z czynników, ale moim zdaniem nie jest on krytyczny. O co chodzi ze złym sąsiedztwem?

Firma hostingowa ma setki, czasem nawet i tysiące stron na jednym serwerze, na jednym adresie IP. Jeśli więc jedna z takich stron „nabroi” – czyli na przykład są na niej wirusy, trojany, czy jakieś inne złośliwe treści, to może to rzutować na autorytet pozostałych stron, pozostałych domen utrzymywanych na tym serwerze.

Jednak, Google raczej podchodzi do tego zdroworozsądkowo i też doskonale rozumie tę sytuację, że większość stron znajduje się na hostingach współdzielonych, no i są one podatne na efekt tego złego towarzystwa, więc tak naprawdę, aby dostać karę za takie złe towarzystwo, przynajmniej wg Matta Cuttsa, trzeba wpaść naprawdę w bardzo, bardzo złe towarzystwo:

Zatem złe towarzystwo z punktu widzenia krótkoterminowego Google – może mieć wpływ na Twoją pozycję, głównie jeśli jest naprawdę bardzo złe. Zazwyczaj nie powinno wpływać na SERP’y. Natomiast w długim terminie i tak szerzej na to patrząc, to złe towarzystwo będzie negatywnie wpływało na reputację Twojej domeny czy Twojej strony, zwłaszcza w przypadku współdzielonych adresów IP i może dojść do sytuacji, w której właśnie strona będzie blokowana chociażby poprzez skanery antywirusowe.

Jeśli masz własne przemyślenia na temat tych kryteriów – śmiało, podziel się Twoim zdaniem w komentarzu, daj znać, co sądzisz o tych kryteriach, może masz jakieś własne – bardzo chętnie poznam Twoje zdanie. Myślę, że to jest taki temat, który budzi emocje, więc po prostu rozmawiajmy, dyskutujmy, dzielmy się poglądami.

Ja nie zgodzę się z ekspertami, wymienionymi w artykule Faktem jest, że jeśli strona ładuje się 0.5 sekundy to kolejne 3-4 sekundy mogą mieć małe znaczenie. Zazwyczaj spotykanym jest jednak przypadek, że strona ładuje się 8 sekund, zamiast 4 i to już może zwyczajnie irytować użytkowników. Jeśli rozpatrujemy kiepską wydajność w długim terminie, to doprowadzamy do sytuacji, że użytkownicy wybierają inne strony, bo nasza ich po prostu irytuje. Stąd prosta droga do obniżenia pozycji lub problemów z ich uzyskaniem, ponieważ sygnały od użytkowników będą zyskiwać na znaczeniu, a wolny serwer to marnowanie zasobów co w drodze do zero emisyjności jest niedopuszczalne

Faktem jest, że jeśli strona ładuje się 0.5 sekundy to kolejne 3-4 sekundy mogą mieć małe znaczenie. Zazwyczaj spotykanym jest jednak przypadek, że strona ładuje się 8 sekund, zamiast 4 i to już może zwyczajnie irytować użytkowników. Jeśli rozpatrujemy kiepską wydajność w długim terminie, to doprowadzamy do sytuacji, że użytkownicy wybierają inne strony, bo nasza ich po prostu irytuje. Stąd prosta droga do obniżenia pozycji lub problemów z ich uzyskaniem, ponieważ sygnały od użytkowników będą zyskiwać na znaczeniu, a wolny serwer to marnowanie zasobów co w drodze do zero emisyjności jest niedopuszczalne

Dzięki za głos w dyskusji. Być może przytoczone osoby po prostu w mniejszym stopniu pracują ze stronami o takich czasach ładowania, jak Ty wspominasz. Jestem podobnego zdania – kiedy strona wczytuje się 8-10 sekund, to brzmi źle z kilku powodów: Wyczerpanie budżetu crawlowania oraz zniechęcenie użytkownika – a słaby wynik Core Web Vitals tylko to potwierdzi. Kiedy strona jest zniechęcająca, trudniej też o naturalne linkowanie czy choćby polecanie samej marki w sieci – a co do zasady są to w SEO dość pożądane elementy. Dlatego szybkość moim zdaniem ma znaczenie.