Data center, czyli centra danych – to fascynujące obiekty. Cyberfolks.pl rozwija się szybko i potrzebowaliśmy niedawno większej powierzchni. Wprowadzając się do nowego centrum danych w Krakowie pomyśleliśmy, że podzielimy się z Tobą kilkoma faktami na temat działania takich centrów. Jak zatem działają takie obiekty i dlaczego są tak ważne nie tylko dla Ciebie, ale wręcz – dla ludzkości?

Ten wpis powstał z myślą o:

- Właścicielach stron i sklepów, którzy chcą wiedzieć, jak w praktyce wygląda utrzymanie ich danych na serwerach.

- Wszystkich zainteresowanych nowoczesnymi technologiami i tego, jak dokładnie wygląda technologia serwerowa, napędzająca działanie społeczeństwa informacyjnego.

- Przedsiębiorcach lubiących dokładnie rozumieć, za co płaci się firmie hostingowej, kiedy rozmawiamy o rzeczywistych kosztach utrzymania danych.

Data center – co to właściwie jest?

Na świecie funkcjonują setki milionów stron www. Z wielu z nich korzystamy codziennie. Zastanawiasz się, co sprawia, że strona www w ogóle działa? Gdzie firmy hostingowe mieszczą się te wszystkie miliardy bajtów danych, które każdego dnia wertujesz w telefonie i na ekranie komputera?

Dane przechowywane są w specjalistycznych obiektach, zwanych centrami danych (ang. data centers). Te rozwijają się niezwykle dynamiczne. Wśród wielu z nich możemy zobaczyć projekty niezwykle efektowne, np. jak ten zbudowany przez należący do Microsoftu Github, czyli Github Arctic Code Vault, zbudowany z myślą o tym, aby żadna z katastrof, jaka może nawiedzić Ziemię, nie zniszczyła bezpowrotnie przechowywanych danych o charakterze open-source. To centrum przygotowane z myślą o ok. tysiącu lat przechowywania!.

Innym interesującym podejściem, także reprezentowanym przez Microsoft, jest zatopienie blisko tysiąca serwerów… w morzu, wewnątrz stalowej tuby, wraz z całą infrastrukturą chłodzącą. Projekt Natick miał zweryfikować możliwości przetwarzania danych w morskich głębinach, a tuba – jak widać na zdjęciu – bardzo spodobała się morskim organizmom.

W związku z dynamicznym rozwojem polskie firmy również inwestują w nowoczesne data center. W chwili publikacji tego wpisu trwa proces migracji części zasobów do Data Center Soul, którego właścicielem jest Netia S. A. Obiekt będzie obsługiwał usługi serwerów dedykowanych, które w związku z rozwojem firmy – przestały się już mieścić w dotychczasowym obiekcie w Krakowie, a sama migracja obejmuje kilkadziesiąt szaf z serwerami.

Centrum danych a serwerownia – czy to na pewno to samo?

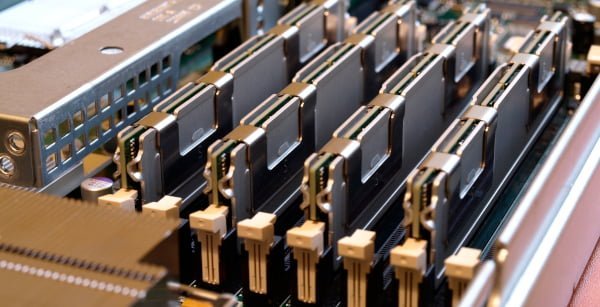

Centrum danych to obiekt, w którym przechowywane są znaczne zasoby danych. Najczęściej w szafach, czyli pionowych konstrukcjach, mieszczących w sobie serwery, macierze dyskowe i urządzenia sieciowe, ułożone w formie płaskich kaset. Szafy ustawione są jedna obok drugiej na terenie serwerowni, czyli głównego pomieszczenia centrum danych.

Tu warto odnotować, że centra danych zajmują olbrzymią powierzchnię. Dla przykładu Netia Data Center Soul w Krakowie, do którego aktualnie przenosimy część zasobów, zajmuje przestrzeń 3.500 metrów kwadratowych, tyle samo, co połowa stadionu FC Barcelona!

W centrum danych znajduje się kilka osobnych komór, przeznaczonych na sprzęt serwerowy. Taka część nazywa się serwerownią. W skład centrum wchodzą też dodatkowe pomieszczenia, mieszczące niezbędną infrastrukturę. Jaką konkretnie? O tym za moment.

Data center – częste nieporozumienie

Kiedy użytkownicy są zadowoleni z działania strony, czasem komentują, że właściciel serwisu “ma dobrą serwerownię”. W rzeczywistości serwerownia to po prostu główne pomieszczenie w centrum danych.

Najczęściej w niewielkim stopniu serwerownia, czy też całe centrum danych, wpływa na to, jak szybko strona wczytuje się użytkownikowi. Tu wiodącą rolę ma kod strony, łącza oraz konfiguracja serwera, za którą odpowiada firma hostingowa. Zatem za to, jak szybko wczytuje się Twoja strona odpowiada kilka podmiotów. Centra danych wpływają przede wszystkim na niezawodność i bezpieczeństwo – to tutaj przede wszystkim ujawniają się ich zalety.

Ciągłość zasilania

Naturalnie, aby Twoje usługi w Sieci działały nieprzerwanie, kluczowe jest zapewnienie niezawodności w obszarze zasilania w energię elektryczną. Aby było to możliwe, niezbędne jest przygotowanie infrastruktury. W wypadku krakowskiego centrum danych jest to ok. 300 km kabli. Gdyby je wszystkie połączyć w jedną, prostą linię, moglibyśmy praktycznie przesłać nią prąd z Krakowa do Poznania!

Najważniejsze z punktu widzenia ciągłości działania są takie elementy infrastrukturalne jak pomieszczenia UPS, transformatory, agregaty prądotwórcze, ale nim przejdziemy do wyjaśnienia czym są te elementy należy zrozumieć pojęcie redundancji – czyli nadmiarowości.

Redundancja

Oznacza, że posiadamy więcej elementów, niż jest to konieczne do zapewnienia stabilnej pracy danego systemu. Przykładowo w serwerze mamy dwa zasilacze. Jeśli jeden z nich uległby uszkodzeniu – serwer wciąż będzie działał, ponieważ nawet pojedynczy zasilacz ma moc niezbędną do zachowania jego pracy. W wypadku centrów danych zasilacze są wymienialne “na gorąco” – czyli w razie awarii zasilacz jest wymieniany bez wyłączania serwera.

Aby zachować maksymalny poziom niezawodności oba zasilacze w centrach danych są zazwyczaj podpinane pod oddzielne tory zasilania. Niesie to dwie istotne zalety:

- W razie awarii (np. zwarcie, zadziałanie bezpiecznika na jednym z torów) prąd przestanie płynąć do danego zasilacza, ale drugi – pozostanie sprawny.

- Takie połączenie umożliwia prowadzenie prac konserwacyjnych i kontrolowane odłączanie torów zasilania, w celu wykonania na nich niezbędnych prac.

Łączna moc szczytowa w centrum danych Netia Soul to 5.000.000 W – taka moc byłaby w stanie zasilić osiedle ok. 350 domów jednorodzinnych! To blisko połowa mocy Nautiliusa – pierwszego amerykańskiego okrętu podwodnego z napędem atomowym, a można powiedzieć, że w skali światowej spotkać można obiekty znacznie większe, o jeszcze większym zapotrzebowaniu na moc elektryczną.

Aby tę moc dostarczać nieprzerwanie – stosowane są UPS’y oraz generatory. UPS’y to – w uproszczeniu – potężne zestawy akumulatorów wraz z elektroniką sterującą ich działaniem. Być może kojarzysz je zabezpieczenia sprzętów biurowych. To one dostarczają prąd, niejako zapewniając “bufor” na wypadek awarii sieci zewnętrznej. Napięcie jest podawane w sposób bezprzerwowy, dzięki temu serwery zachowują ciągłość działania nawet w obliczu odcięcia napięcia z zewnątrz. Naturalnie, tutaj liczba akumulatorów jest nieporównanie większa – potrzebne są całe, dedykowane pomieszczenia tylko do przechowywania regałów z potężnymi akumulatorami.

Stosowane są przy tym osobne zestawy UPS do zasilania serwerów oraz urządzeń klimatyzacji precyzyjnej – bowiem do działania serwerów niezbędny jest zarówno prąd, jak i stałe chłodzenie.

Mimo faktu, że mówimy o wielotonowych stosach akumulatorów, energia w nich zgromadzona tak naprawdę nie jest potrzebna zbyt długo – przede wszystkim przez czas niezbędny do uruchomienia generatorów awaryjnych (liczony w sekundach).

W obiekcie, do którego cyberfolks.pl się obecnie wprowadza w Krakowie, są 4 generatory, utrzymywane w stanie ciągłej gotowości, o mocy 2000 kVA każdy.

15 okrążeń

Tyle razy Ziemię może objechać dookoła mały samochód osobowy, bazując na paliwie zgromadzonym do zasilania agregatów prądotwórczych.

Potężna instalacja bazuje nie tylko na tradycyjnych, elastycznych przewodach, ale na tzw. szynoprzewodach, zdolnych do obsługi natężeń prądu rzędu 3200 A! Obrazowo mówiąc – tak wielkie natężenia są przesyłane po prostu specjalnymi szynami, które są w stanie przesyłać prąd o natężeniach setki razy większych niż te znane z domowej sieci. Tego typu instalacje są jedynym sensownym rozwiązaniem przy przesyłaniu tak ogromnych prądów, jakie są niezbędne do funkcjonowania centrum danych.

Chłodzenie w data center

Chłodzenie w centrach danych to zagadnienie wymagające szczególnego podejścia – serwery wytwarzają bowiem podczas pracy wyjątkowo dużo ciepła. Nie wystarczy jednak schłodzenie “jakiekolwiek”. Agregaty chłodnicze muszą działać nieprzerwanie i wykazywać się ogromną wytrzymałością i wydajnością. Także tutaj niezbędna jest redundancja – czyli zapewnienie większej ilości zasobów, niż jest to potrzebne do zachowania ciągłości działania.

W wypadku klimatyzacji obsługującej centrum danych koniecznie jest wyjątkowe dbanie zarówno o temperaturę, jak i o wilgotność. Chodzi o to, że powietrze zbyt suche powoduje zwiększenie ryzyka wyładowań elektrostatycznych, podczas gdy powietrze nadmiernie wilgotne powoduje ryzyko powstania skroplin w niepożądanych miejscach. W obu wypadkach skutki dla sprzętu serwerowego pod napięciem byłyby zgubne.

Cały sprzęt serwerowy jest ustawiony w oparciu o filozofię zimnych i ciepłych naw. Serwery od przodu pobierają chłodne powietrze, a następnie przepływa ono przez serwer i jest wyrzucane do tyłu, do tzw. nawy gorącej. Klimatyzacja o wysokiej gęstości pozwala na umieszczenie sprzętu o mocy nawet kilkunastu kW w każdej szafie.

Ochrona przeciwpożarowa

Centra danych to obiekty szczególne i wymagają szczególnego podejścia do detekcji i zwalczania pożarów. System VESDA potrafi wykryć minimalną ilość dymu (wystarczy jeden spalony zasilacz wśród setek serwerów) i podnieść alarm.

Odrębnym systemem jest system detekcji wodoru, związany z potężnymi bateriami akumulatorów – to technologia zbliżona do tych, znanych z okrętów podwodnych. Chroni przed niekontrolowanym wybuchem gazu.

Ogromnym wyzwaniem jest szybkie gaszenie. Po centrach danych nie biega się z gaśnicami, ani nie zalewa ich wodą. Z oczywistych powodów gaszenie takiej ilości wrażliwego sprzętu elektrycznego pod napięciem przebiega inaczej.

Stosowane są przede wszystkim instalacje oparte o wypieranie tlenu z powietrza. Ponownie są to zaadaptowane z marynarki wojennej rozwiązania. Kiedy usuniemy tlen – spalania nie będzie. Dlatego w centrach danych składuje się ogromne butle ze specjalnymi gazami gaśniczymi. Gaz jest tam zgromadzony pod ogromnym ciśnieniem rzędu 300 barów (dla porównania: ciśnienie w oponie auta osobowego to ok. 2 bary). Nowszy system, stosowany w data center Soul to gaz FM200/Novec – pracuje on na niższych (choć wciąż ogromnych) ciśnieniach 42 bary. Dlaczego?

10 sekund

Tyle trwa wypełnienie gaszonego pomieszczenia gazem wypierającym tlen z powietrza

Ciśnienie musi być wysokie, by w razie pożaru gaz został szybko uwolniony. Wypełnienie pomieszczenia gazem trwa to ok. 10 sekund. Brzmi to jak prosta teoria, a w praktyce trzeba brać pod uwagę jeszcze takie elementy, jak to, czy w gaszonym pomieszczeniu ma przeżyć człowiek (tlen!), nagły skok ciśnienia czy… hałas!

Ten ostatni czynnik okazuje się szczególnie groźny na współczesnych dysków twardych o wysokiej gęstości. Takie dyski w obudowie o średnicy zaledwie 3.5 cala potrafią zmieścić kilkanaście TB danych. To jakby na jeden dysk zapisać 5 milionów dobrej jakości zdjęć, 200 osób przez całe życie musiałoby codziennie robić zdjęcie, aby zapełnić taki dysk. Praca głowicy unoszącej się na poduszce powietrznej nad dyskiem wirującym z szybkością 7200 obrotów na minutę, z tak gęsto upakowanymi danymi, to prawdziwy popis mechanicznej precyzji. Huk fali dźwiękowej, spowodowany wystrzałem gazu gaśniczego, może doprowadzić do niekontrolowanego przesunięcia tak precyzyjnie pracującej głowicy i spowodować uszkodzenie danych (lub nawet nośnika).

Fizyczne bezpieczeństwo

Skoro wiesz już, jak zbudowane jest centrum danych, masz też świadomość, że tego rodzaju obiekt to nie jest zwykłe pomieszczenie biurowe. Konieczne jest zastosowanie w nim adekwatnych środków ochrony – m.in. system uprawnień, kart dostępowych. W krakowskim obiekcie jest ponad 70 punktów kontroli dostępu, działających w oparciu o wpisanie PIN oraz skanowanie biometryczne.

Bezpieczeństwa fizycznego strzeże kilkadziesiąt czujników ruchu. Każde drzwi są wyposażone w czujnik otwarcia, a wokół ogrodzenia znajdują się bariery podczerwieni. Obiekt oczywiście jest całodobowo chroniony.

Promieniowanie kosmiczne a serwery

Dane muszą być chronione nie tylko przed ludźmi. Twoje dane chronimy także przed zagrożeniami… z kosmosu!

Informacje w modułach pamięci są przechowywane w postaci ciągów zer i jedynek. Promieniowanie kosmiczne, mimo, że w znacznym stopniu redukowane przez atmosferę ziemską, potrafi doprowadzić do przestawienia bitów – zamiany zera i jedynki. Jak nietrudno zgadnąć, skutki zależą od tego, czego dotyczyła informacja w pamięci – mogą być praktycznie niezauważalne (np. jedna niewłaściwa litera w długim tekście), albo bardzo poważne (np. zawieszenie serwera, nieprawidłowa operacja w bazie danych itp.).

Dlatego stosowane rozwiązania bazują na korekcji i detekcji błędów ECC. To specjalny układ przechowujący sumę kontrolną bajtu pamięci. W razie, gdyby którykolwiek bit uległ przestawieniu – układ przywraca mu właściwą wartość.

Ciekawostka – ta technologia pochodzi z kosmosu – miała zastosowanie m.in. przez NASA podczas misji kosmicznych. Sonda kosmiczna Cassini, badające pierścienie Saturna, notowała 240 błędów pamięci RAM na dobę!

Dane na dyskach twardych

Dane w pamięci trwałej są także szczególnie chronione i tu znów pojawia się zagadnienie redundancji. Są one zapisywane jednocześnie na więcej niż jeden nośnik. W odniesieniu do dysków mechanizm ten nazywamy RAID. Dzięki niemu dane znajdują się jednocześnie na wielu nośnikach (fizycznych dyskach) i w razie awarii możemy wymienić wadliwie działający dysk, bez utraty zapisanych na nim informacji. Po wymianie komponentu zostaną one odbudowane w oparciu o nowy napęd. W ten sposób w razie awarii dysku – dane nie są tracone.

Redundancja chłodzenia

Prawdopodobnie słyszysz czasem wentylator włączający się podczas pracy komputera lub laptopa. W wypadku serwerów mówimy o wielu małych wentylatorach, które dbają o odpowiednią cyrkulację powietrza między komponentami serwera tak, aby odbierać ciepło z gorących dysków, procesorów czy modułów RAM i przepychać je ku tyłowi urządzenia.

W wypadku profesjonalnych serwerów urządzenie jest odporne na awarię takiego wentylatora. Gdyby do niej doszło – pozostałe wentylatory zwiększają automatycznie swoje obroty tak, aby zapewnić taki sam przepływ powietrza. Uszkodzony moduł wentylatora wymienić można bez przerywania pracy urządzenia.

Dodatkowe rozwiązania

Kolejna sprawa, to specjalny procesor diagnostyczny. Pozwala on na diagnozowanie sprzętu i raportowanie każdej usterki czy istotnych parametrów pracy. Dzięki niemu nasi specjaliści są w stanie np. odczytać temperatury w każdym serwerze i to w wielu jego punktach. Możemy też np. dowiedzieć się, że jakiś moduł pamięci RAM wyraźnie częściej dokonuje korekcji błędów niż inne, a co za tym idzie – możliwe, że należy go wymienić zanim spowoduje to usterkę.

Większość usterek, jakie zdarzają się w obszarze centrum danych czy infrastruktury serwerowej – jest tak naprawdę nieodczuwalna przez klientów. To dzięki wspomnianej kilkukrotnie redundancji, czyli zasadzie, w myśl której mamy więcej komponentów, niż jest to wymagane do pracy danego systemu.

Inne ciekawostki, używane w inżynierii serwerowej, które przekładają się na niezawodność usług oraz czasy reakcji to, między innymi:

- dioda UID, zapalana jednocześnie po obu stronach serwera, dzięki czemu łatwo zidentyfikować konkretne urządzenie w całej szafie identycznych serwerów. Dioda jest zapalna z dowolnego miejsca na Ziemi,

- narzędzia serwisowe – przyczepione w „łapkach” w obudowie serwera, żeby zawsze od razu były pod ręką, kiedy są potrzebne,

- schematy serwisowe, związane z wymianą kluczowych komponentów – naklejone na pokrywy ( można błyskawicznie sprawdzić schemat nie przeszukując rozległej dokumentacji).

Nowoczesne centra danych

To specjalistyczne obiekty, dzięki którym funkcjonować mogą firmy hostingowe, portale, dostawcy usług online, największe sklepy internetowe. To technologiczna podstawa, umożliwiająca funkcjonowanie stron internetowych, aplikacji i usług z których korzystasz każdego dnia.

Dlatego, decydując się na wybór firmy hostingowej, warto wiedzieć, jak podchodzi ona do tego rodzaju zagadnień. Czytając opis stosowanych technologii i zabezpieczeń z pewnością umiesz wyobrazić sobie, że profesjonalne przechowywanie danych wiąże się ze znacznymi nakładami finansowymi. Jest to jeden z istotnych składników ceny usług hostingowych. Kiedy więc planujesz wybranie usługi hostingowej z wyjątkowo niską ceną – zadaj sobie pytanie, na którym z tych elementów oszczędzono?

Jeśli interesują Cię te zagadnienia, jeśli chcesz wiedzieć więcej o tym, jak działa hosting „od kuchni” – daj znać w komentarzu. Chętnie podzielimy się innymi ciekawostkami na temat tego, jak wygląda wytwarzanie usług, z których korzystasz.

wszystkie strony są już hostowane w tym centrum w Krakowie czy część jeszcze na ovh w niemczech ?

W centrum danych w Krakowie są uruchamiane serwery dedykowane. Hostingi współdzielone natomiast są uruchamiane obecnie w data center w Gdańsku. Trwa proces migrowania danych z zagranicznych centrów (Holandia, Niemcy) do Polski, usługi zakładane kilka lat temu były rzeczywiście w kilku lokalizacjach zagranicznych, ale nigdy nie korzystaliśmy w tym celu z ovh.

dzięki za odpowiedź; linuxpl był w jakimś datacenter w Niemczech i myślałem że to był ovh

a kiedy będzie migracja reszty serwerów do polski ? głównie mi chodzi strony starego linuxpl z hezner z niemczech ?

Proces przygotowania jest rozpoczęty. Tak wielkie operacje zazwyczaj odbywają się etapami. Będziemy informować klientów z wyprzedzeniem, przede wszystkim drogą mailową.